手把手教你从零开始手搓 DeepSeek-R1 + Chatbox 可视化

近期,DeepSeek 可谓风头无两,一举登顶中美 App Store 效率排行榜榜首。然而,伴随着其火爆程度的飙升,DeepSeek 也遭遇了连续的网络攻击,导致用户在使用过程中频繁遇到“服务器繁忙,请稍后再试”的提示。为了让大家能够更顺畅地体验 DeepSeek 的强大功能,本篇文章将手把手教你如何在本地部署 DeepSeek-R1 蒸馏版(文中会详细解释蒸馏版与完整版的区别)。话不多说,让我们立刻开始吧!

DeepSeek-R1

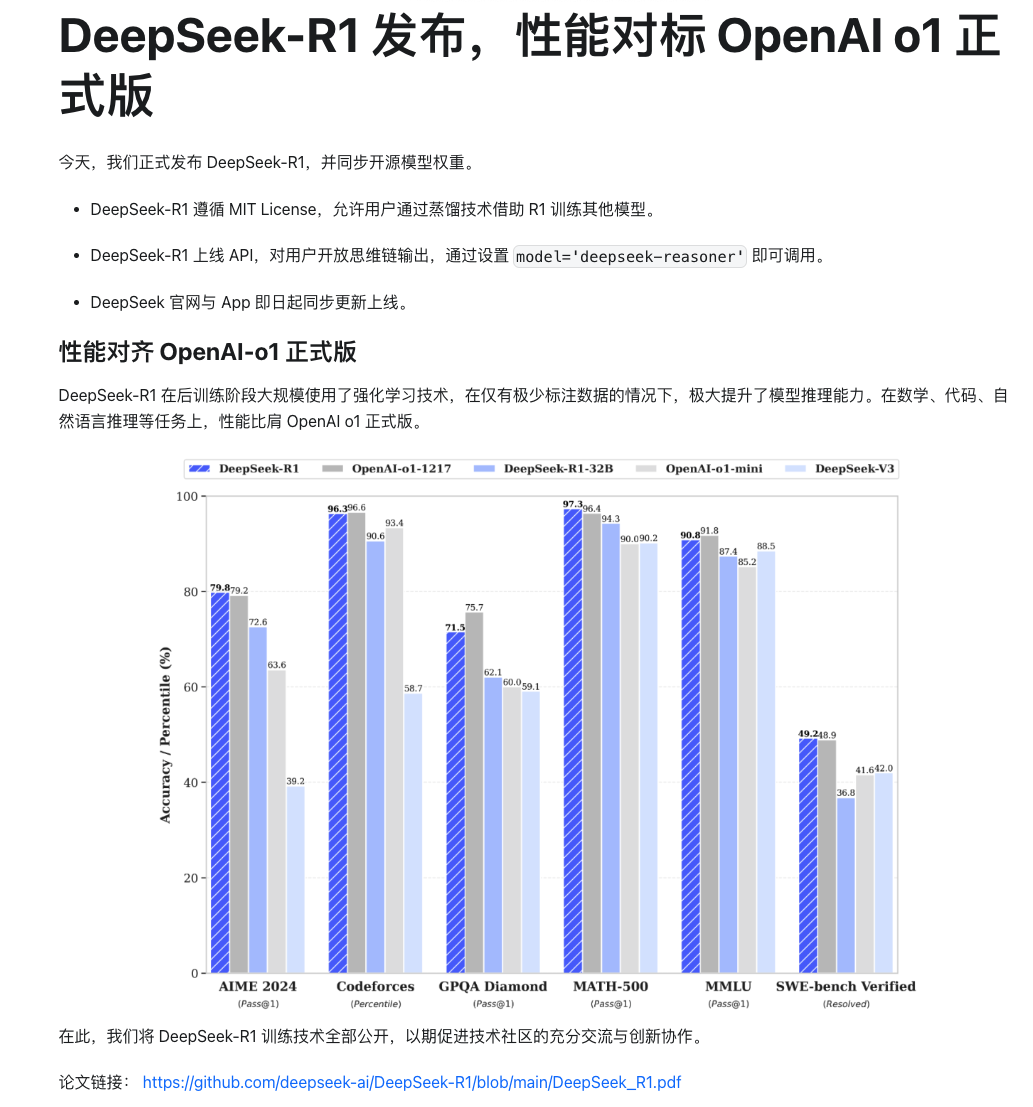

DeepSeek-R1是幻方量化旗下 AI 公司杭州深度求索公司(DeepSeek)在 2025.01.20 推出的高性能推理模型,作为 DeekSeek 的明星产品,该模型能够在极少量标注数据的情况下,通过自主学习和优化来提升推理能力,数学计算,代码生成,逻辑推理等等。

开始部署

本次我们主要采用可视化的方式来进行部署,具体方案为:Ollama + DeepSeek-R1蒸馏版 + Chatbox

1. 安装Ollama

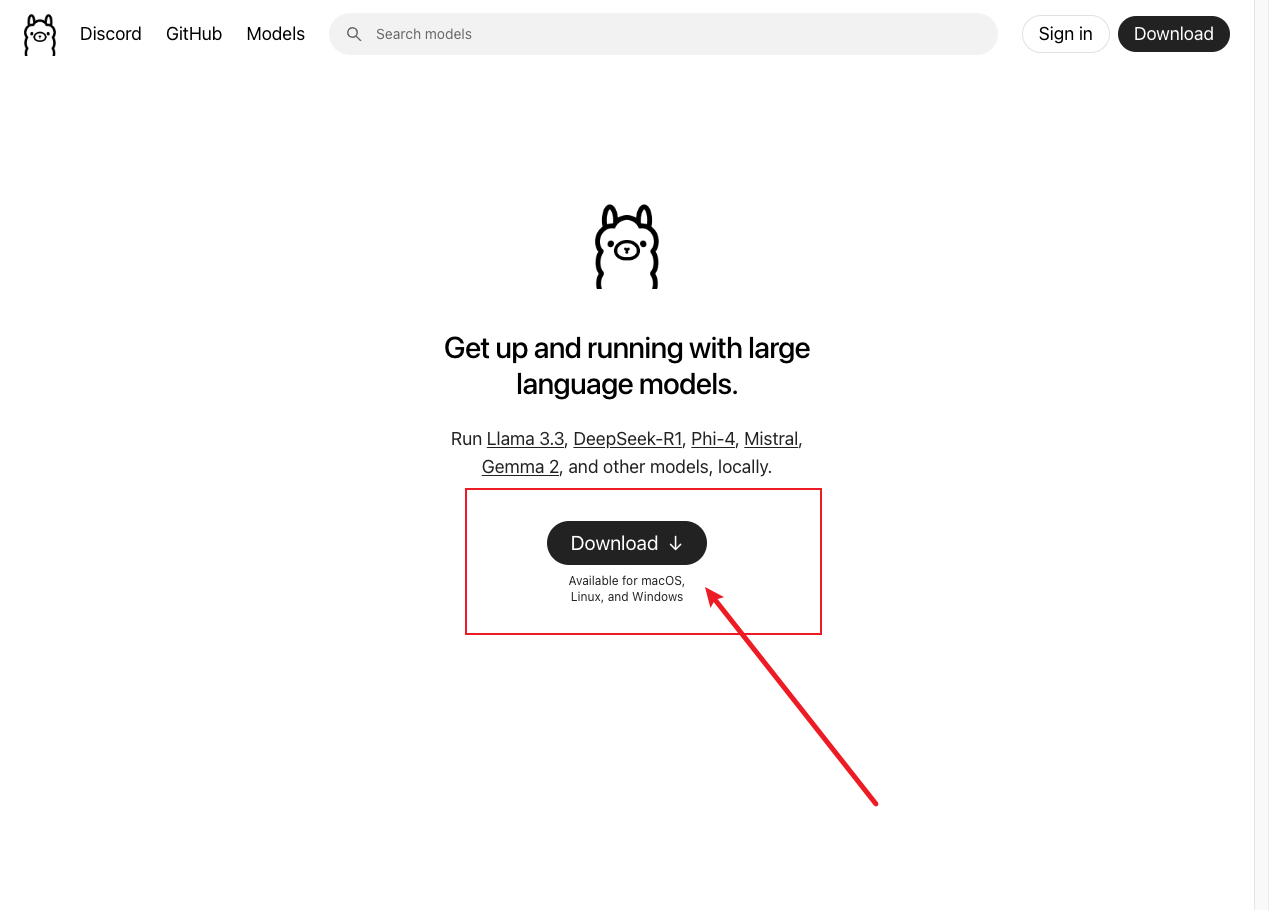

官网链接:https://ollama.com/,简单来说 Ollama 是一个基于 Go 语言开发的简单易用的开源大模型运行框架,通过简单命令即可与大模型进行交互。

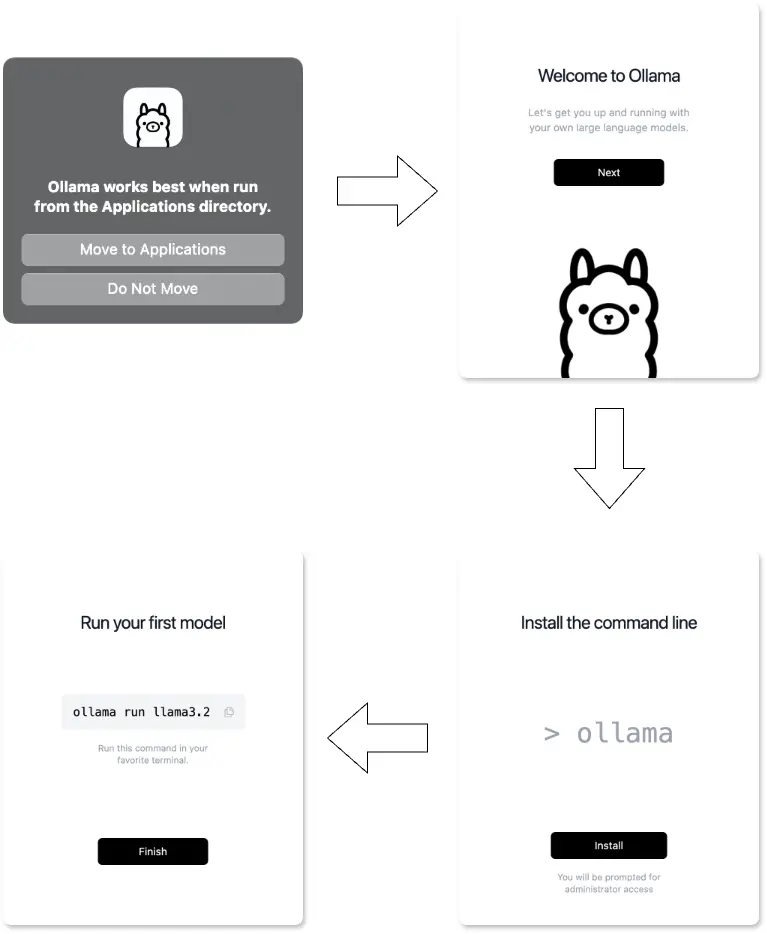

1.1.点击 Download

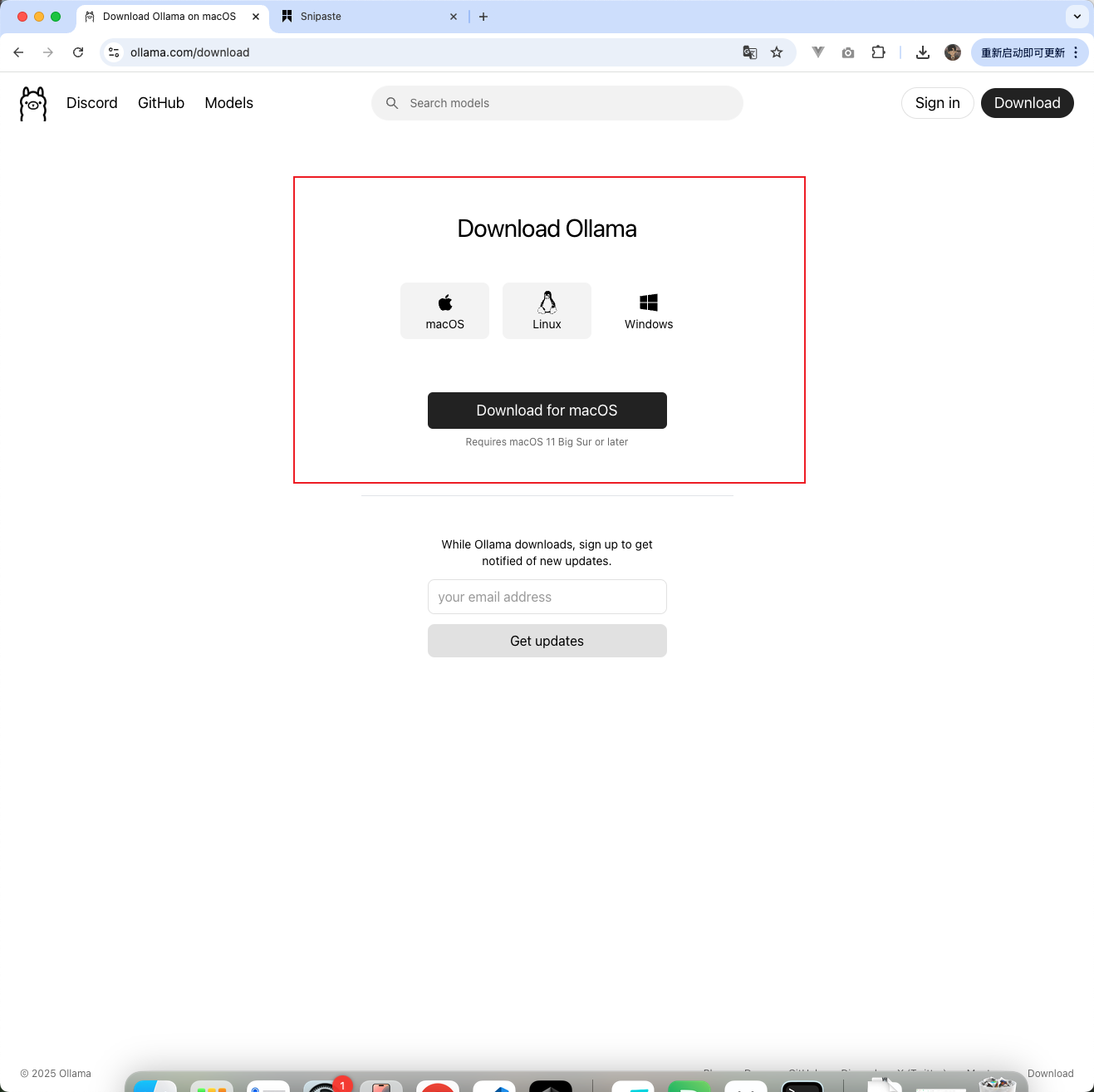

1.2.选择你对应的系统点击 Download

1.3.下载好之后点击安装包安装即可。

这里提供一些 Ollama 的简单命令

- ollama list:显示模型列表。

- ollama show:显示模型信息。

- ollama pull:拉取模型。

- ollama push:推送模型。

- ollama cp:拷贝模型。

- ollama rm:删除模型。

- ollama run:运行模型。

如何检测是否安装成功呢?我们打开终端输入:ollama -v,出现以下内容就代表ollama 安装成功。

以Mac 为例,在顶部导航栏可以看到 llama 的羊驼 LOGO 也代表安装成功,Windows 是右下角展示LOGO

2. 部署DeepSeek-R1

接下来就开始挑选模型啦,但是具体选择哪个模型还是要根据电脑配置来决定的,

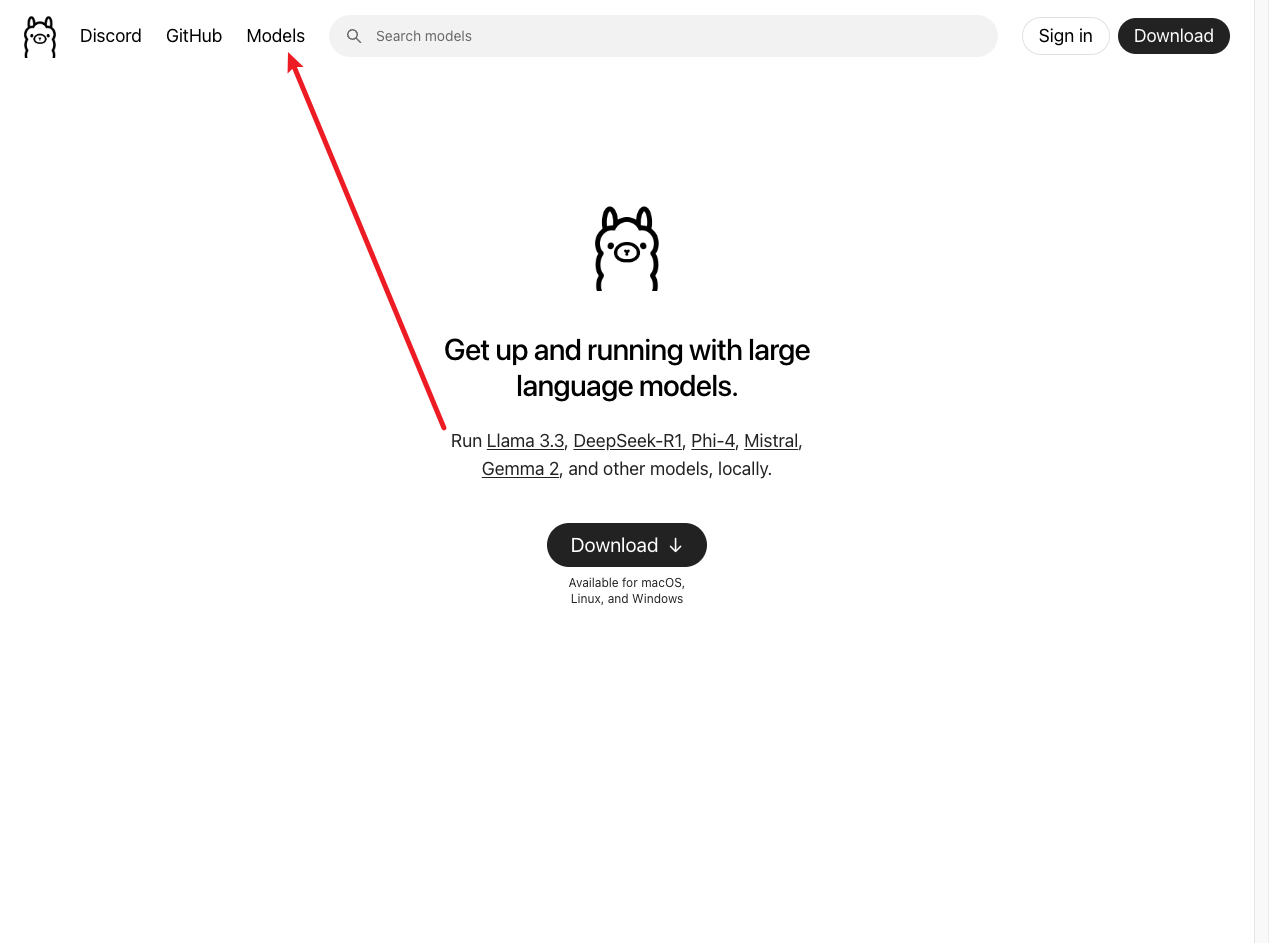

2.1.我们还是来到ollama官网,点击Models。

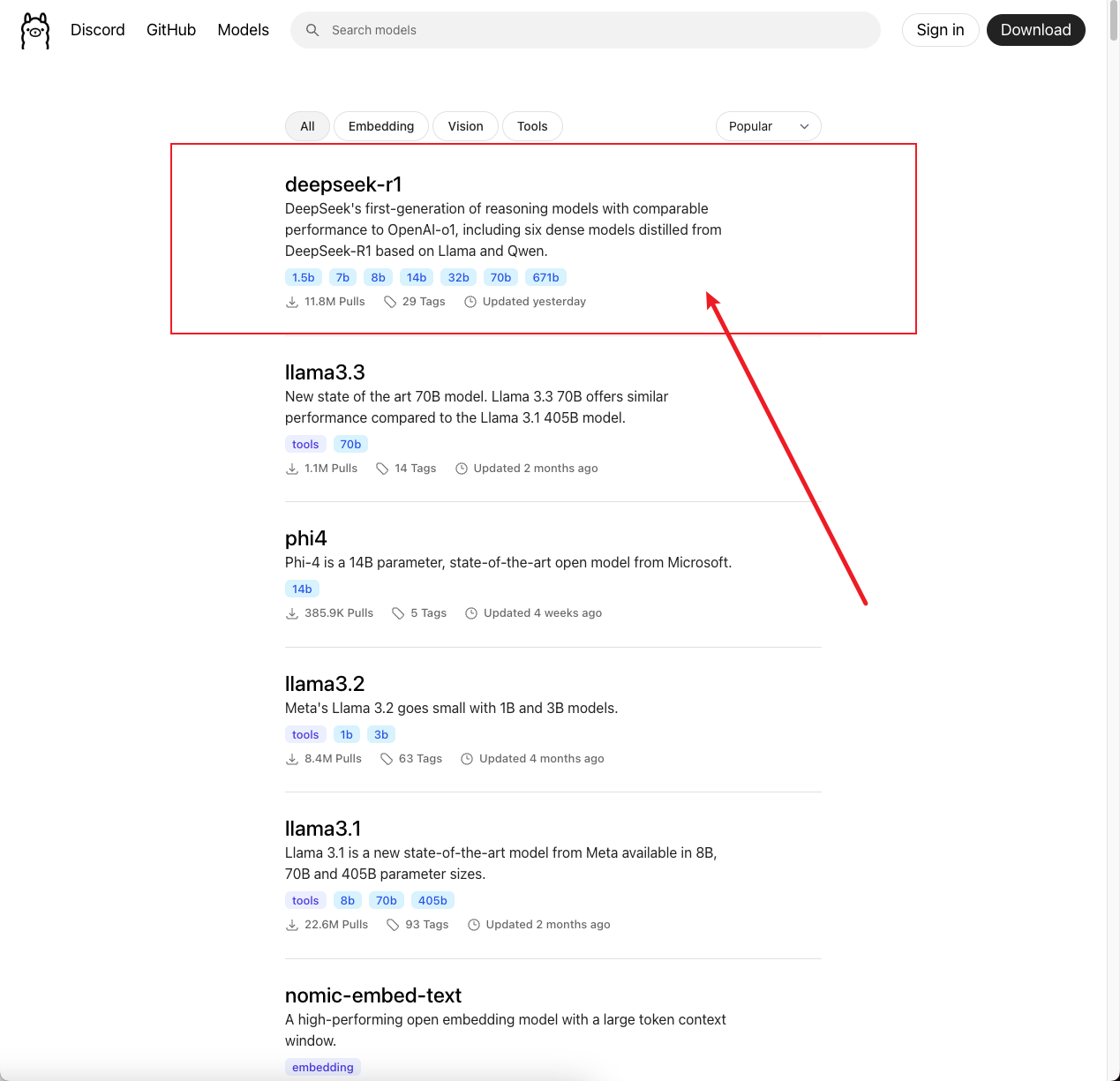

2.2.我们选择第一个 deepseek-r1

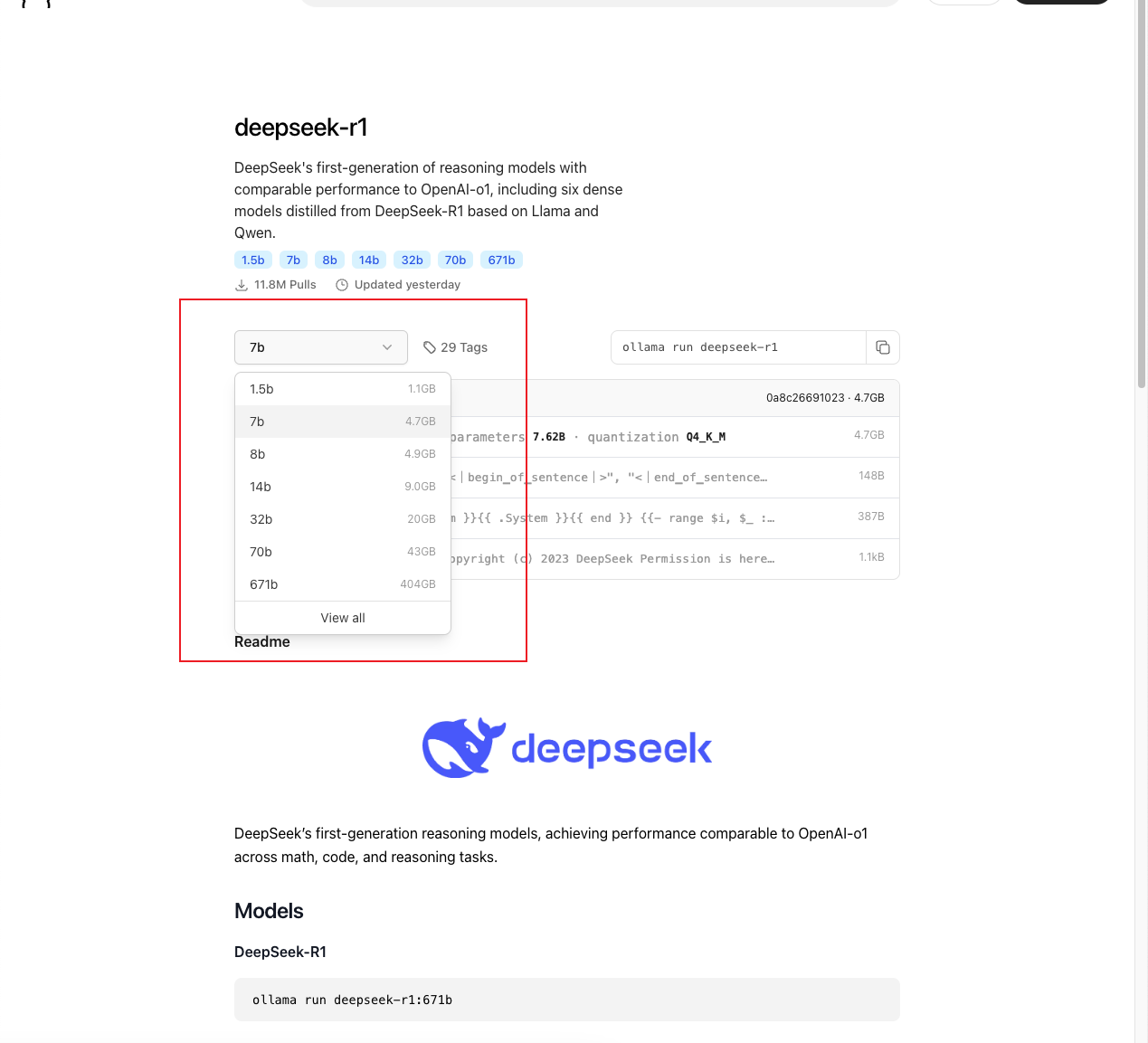

2.3.打开后我们可以看到有很多模型大小供我们选择,这里来解释一下这些数字代表的是模型的大小。

B = Billion(十亿) ,表示模型的参数量。例如:

- 7B:70 亿参数

- 8B:80 亿参数

- 14B:140 亿参数

- 32B:320 亿参数

参数是什么?

模型的参数是神经网络中可学习的权重,参数越多模型越复杂,理论上能处理更复杂的任务,但需要更多计算资源。如何选择,记住这个口诀:

“显存决定上限,内存决定下限,量化决定性价比”

- 显存:决定你能加载多大的模型(直接影响模型能否运行)

- 内存:决定模型运行时是否卡顿(影响流畅度)

- 量化:帮你“压缩”模型,让大模型能塞进小显存

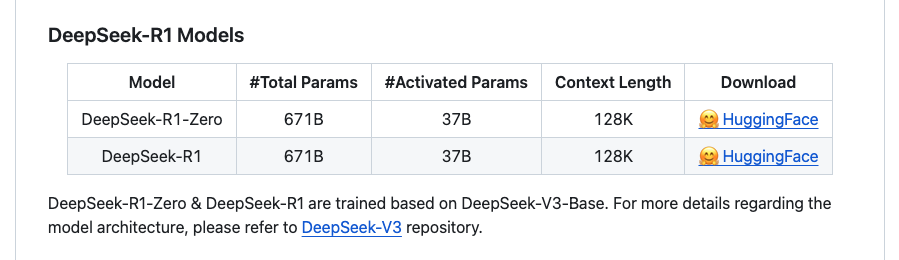

完整版 DeepSeek-R1(671B),光模型大小就 720GB,需要至少 350GB 显存/内存,更适合专业服务器设备来部署。

- 蒸馏版 DeepSeek-R1(1.5B ~ 70B),基于开源模型进行了微调,使用了 DeepSeek-R1 生成的样本,更适用于普通个人用户,硬件要求较低。

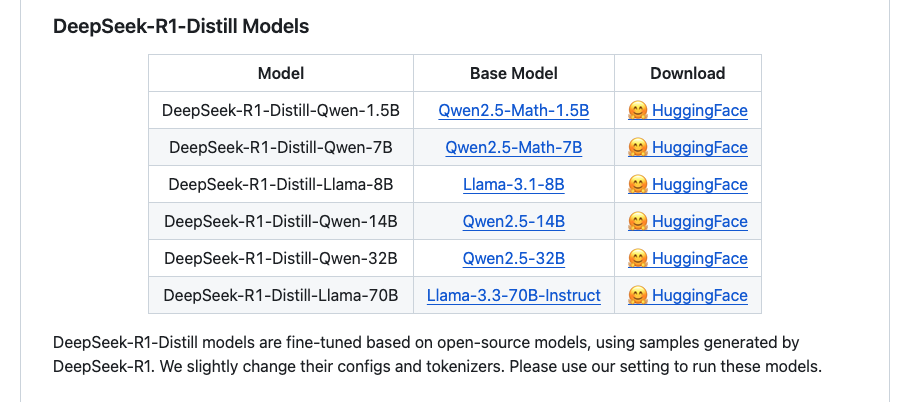

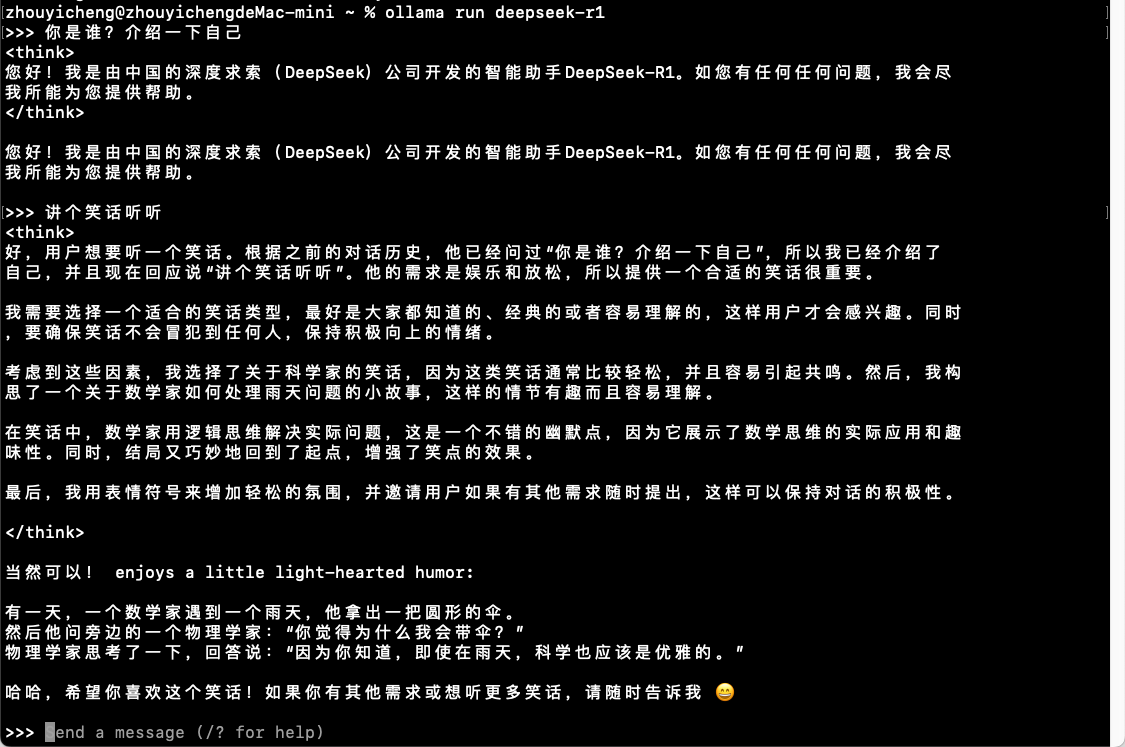

2.4.这里我选择的是 7B 模型,Ollama官网默认下载的也是 7B 模型,复制官网给出的命令到终端运行。

下载 ing…

下载完成后我们就可以和 DeepSeek 进行对话:

3. 安装Chatbox

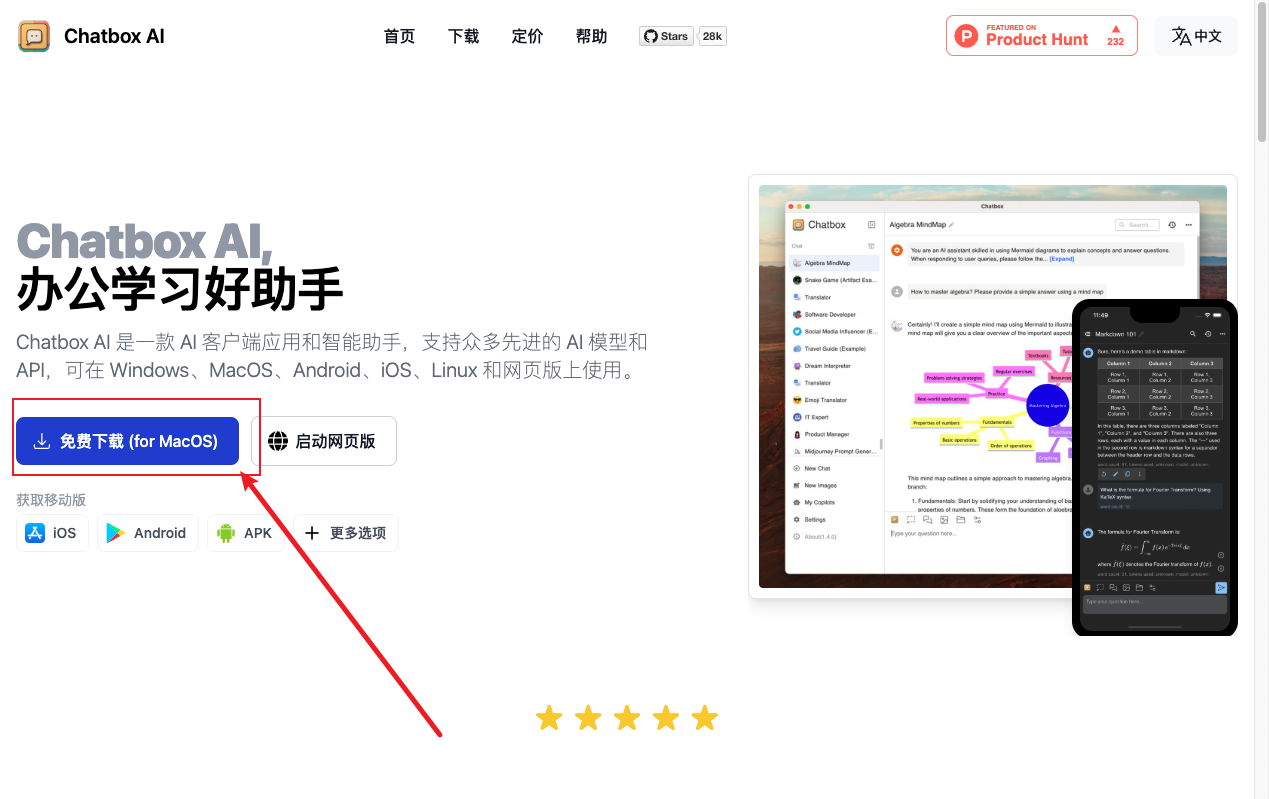

ChatboxAI是一款 AI 客户端应用和智能助手,其简单的配置适合我们直接上手。

3.1.下载对应的安装包进行安装

3.2.安装成功后打开会看到配置提示。

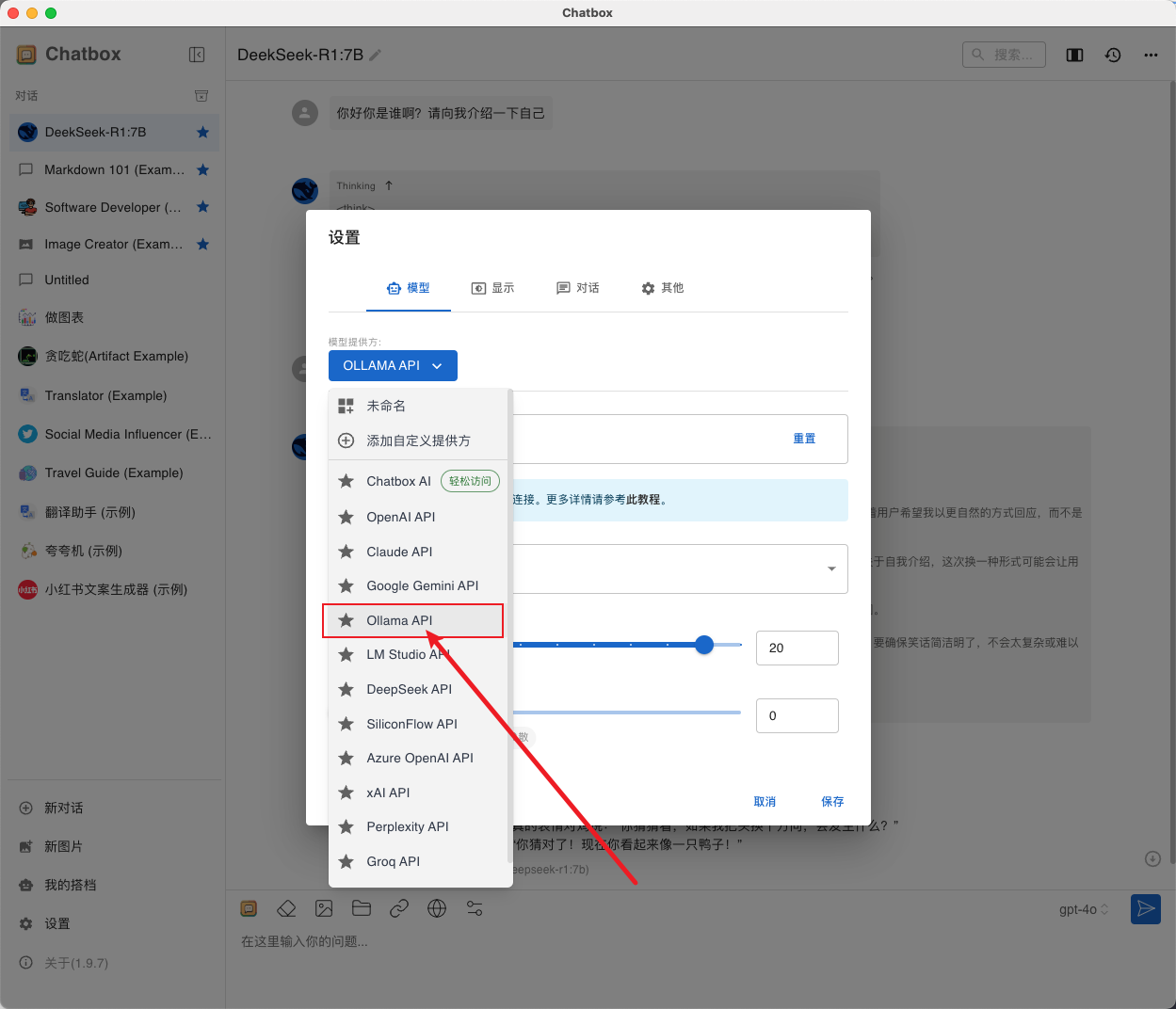

这里我们选择”使用自己的 API KEY 或本地模型”

3.3.选择 OLLAMA API

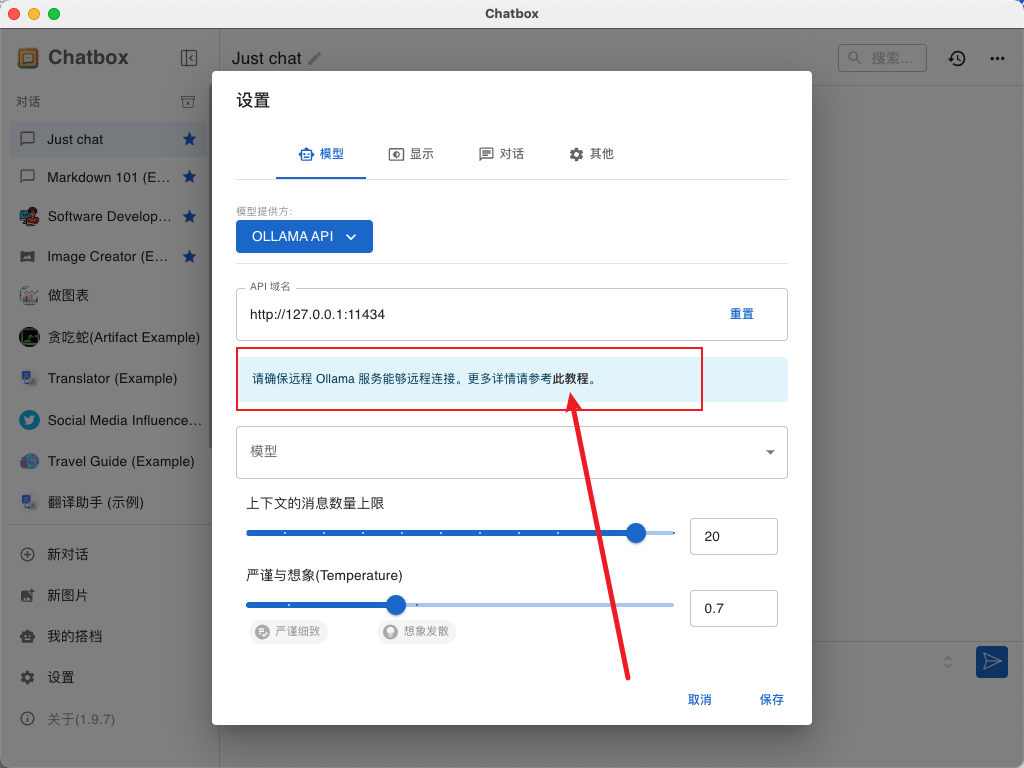

3.4.配置 Ollama Api 的时候要先查看 ChatBox 的环境变量配置文档。

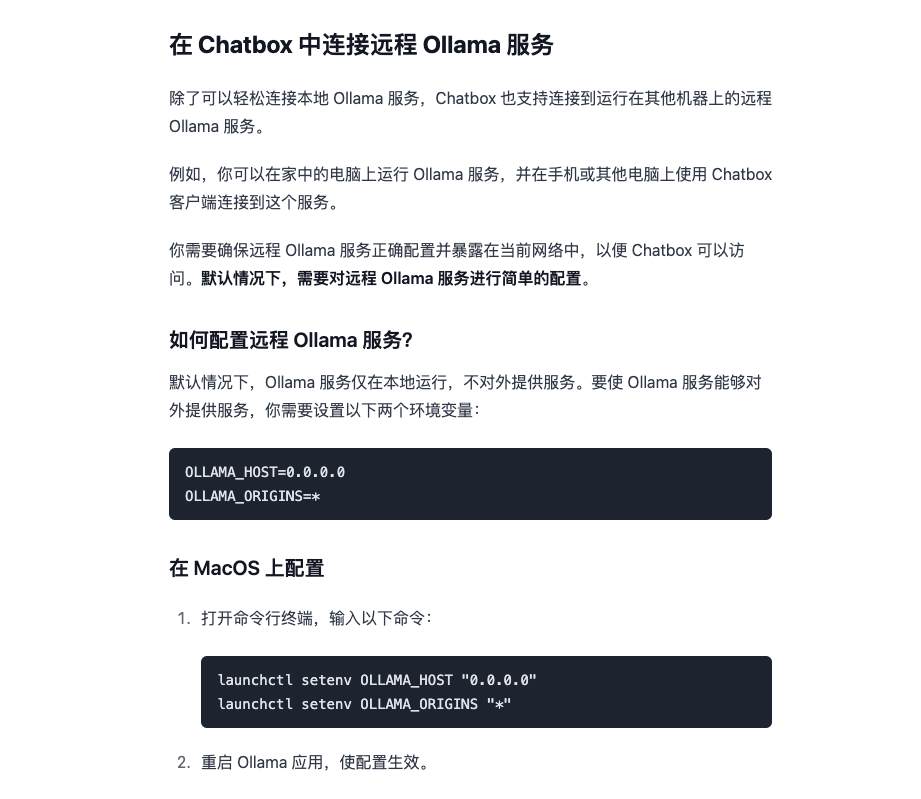

对应的配置文档我也放在下面了哈

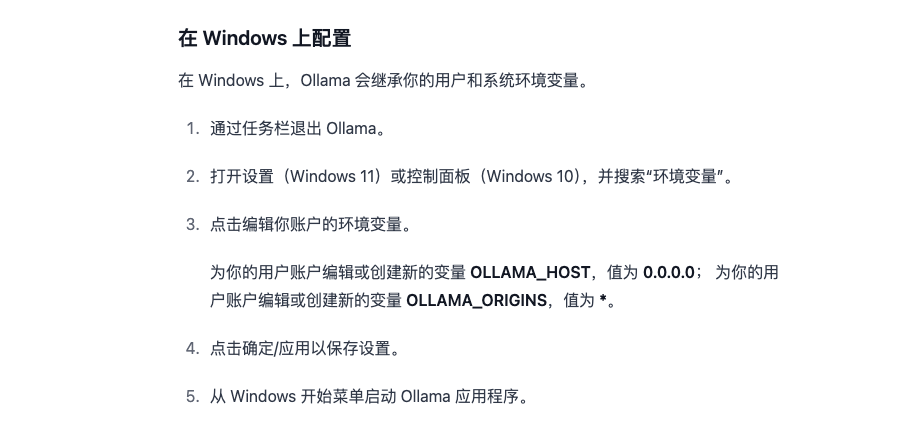

3.5.根据你的系统来选择配置方式

- MacOs

- Windows

- Linux

因为我是 Mac 系统这里按照 MacOS 配置就行。

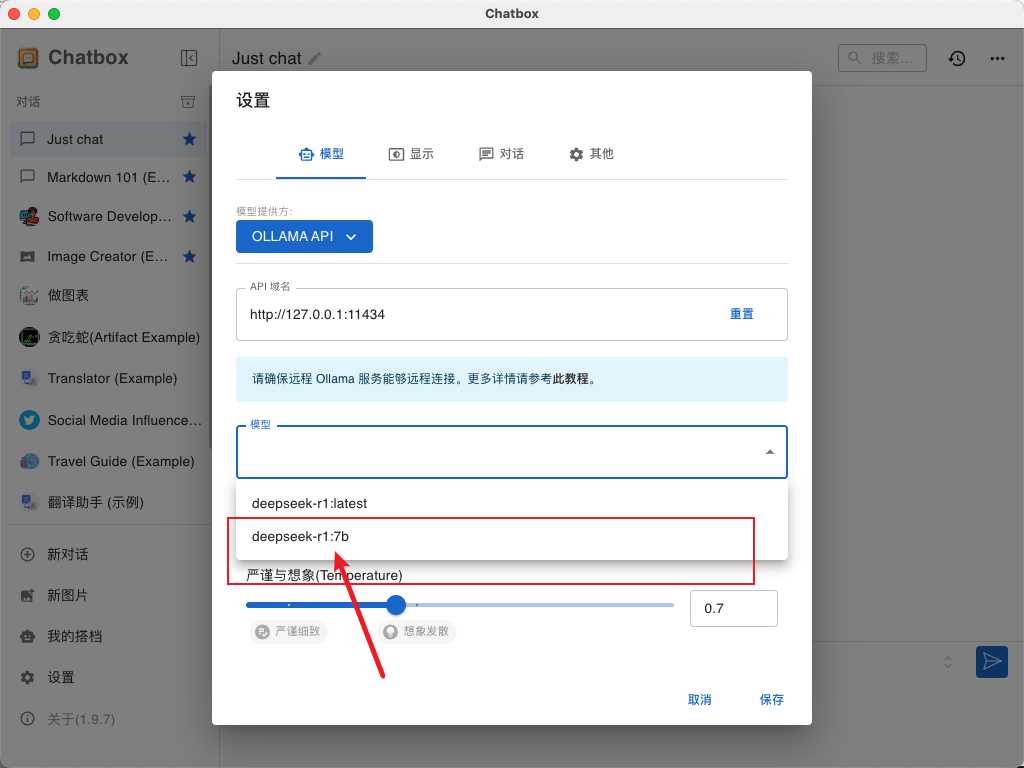

配置完成后回到设置页面,模型就选择你本地部署的模型,我这里是我刚刚安装的 DeepSeek-R1:7B,各位在设置时要选择自己下载的模型名称。

3.6.对话测试

配置成功!

结语

经过几天的体验,蒸馏版 DeepSeek-R1 与完整版 DeepSeek-R1 之间的差距确实较为明显。因此,在本地部署 DeepSeek-R1 尝鲜体验是一个不错的选择,但若想感受 DeepSeek 的完整能力,建议前往官网或其他集成了 DeepSeek-R1:671B 的平台进行体验。希望每位用户都能找到最适合自己的使用方式,享受科技带来的便利与乐趣!